Селекция признаков

10.1. Задача селекции признаков

Рассмотрим этапы решения задачи распознавания образов:

- Генерация признаков – выявление признаков, которые наиболее полно описывают объект.

- Селекция признаков – выявление признаков, которые имеют наилучшие классификационные свойства для конкретной задачи.

- Построение классификатора.

- Оценка классификатора.

Пусть

-

– множество признаков,

– множество признаков, -

– множество признаков, которые нужно отобрать в процессе селекции, причем

– множество признаков, которые нужно отобрать в процессе селекции, причем  .

.

Тогда задача селекции задается следующим образом:  .

.

10.1.1. Постановка задачи селекции признаков.

Пусть задан вектор признаков  . Среди них необходимо выбрать

наиболее информативные, т.е. получить новый вектор признаков

. Среди них необходимо выбрать

наиболее информативные, т.е. получить новый вектор признаков  ,

причем

,

причем  .

.

Определение. Процедура выделения из множества признаков меньшего подмножества с наилучшим сохранением информативности для классификации называется селекцией признаков.

Суть выбора признаков – это выделение признаков, которые приводят к большим расстояниям между классами и к малым внутри классов.

Зачем нужна селекция признаков?

Основной мотивацией для сокращения числа признаков является уменьшение вычислительной сложности. Наряду с признаками, имеющими низкие классификационные способности весьма вероятна ситуация двух хороших признаков (с почти равными классифицирующими способностями), сильно коррелированных между собой.

Вторая причина для уменьшения числа признаков – повышение общности классификатора.

10.1.2. Общность классификатора.

Пусть

-

– число прецедентов,

– число прецедентов, -

– число степеней свободы классификатора (для нейронной сети – это количество синаптических весов).

– число степеней свободы классификатора (для нейронной сети – это количество синаптических весов).

Ясно, что чем больше степеней свободы, тем легче настроить

классификатор. Обозначим через  характеристику общности. Тогда

получаем, что, чем больше

характеристику общности. Тогда

получаем, что, чем больше  , чем выше общность классификатора.

, чем выше общность классификатора.

Чем больше признаков, тем больше  . Поэтому при ограниченном

. Поэтому при ограниченном  уменьшение числа признаков согласуется с уменьшением

уменьшение числа признаков согласуется с уменьшением  , т.е. с

усложнением настройки классификатора.

, т.е. с

усложнением настройки классификатора.

Различают скалярную и векторную селекцию признаков. При скалярной селекции рассматривается отдельно один признак из данного множества. Таким образом, получили одномерную задачу. При векторной селекции одновременно исследуются свойства группы признаков.

10.2. Предобработка векторов признаков

Пусть задано множество признаков.

Селекции признаков предшествует предобработка, позволяющая привести их в единый масштаб измерений и произвести некоторые дополнительные улучшения.

Основные операции предобработки описываются следующими тремя пунктами.

10.2.1. Удаление выбросов – точек, лежащих "очень далеко" от

среднего значения. Обычно измеряется расстояние в средних отклонениях,

например,  ,

,  для нормального распределения.

для нормального распределения.

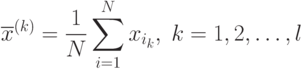

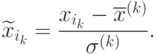

10.2.2. Нормализация. Признаки, имеющие большие значения, могут влиять на классификатор сильнее остальных, что искажает правильность классификатора. Поэтому необходимо уменьшить их влияние путем, который носит название нормализации. Пусть

-

– прецедент,

– прецедент, -

– признаки.

– признаки.

Тогда

Обозначим через

10.2.3. Пропуск данных (потери). По многим прецедентам могут быть известны не все признаки. В таком случае, если данных много, то можно отобрать те у которых набор признаков одинаковый. Если же отбрасывать признаки нельзя, то их можно дополнить, например, с помощью эвристик.