|

В дисциплине "Основы эконометрики" тест 6 дается по теме 7. |

Множественная регрессия

3.9. Проблема мультиколлинеарности факторов

Под мультиколлинеарностью понимается высокая степень коррелированности объясняющих переменных. Крайний случай мультиколлинеарности - линейная зависимость между столбцами информационной матрицы . При этом определитель матрицы

. При этом определитель матрицы равен нулю и не существует обратной матрицы

равен нулю и не существует обратной матрицы . Расчет коэффициентов модели по МНК в этом случае невозможен. Гораздо чаще в экономических исследованиях встречается стохастическая мультиколлинеарность. В этом случае корреляционная связь между факторами высокая, определитель матрицы

. Расчет коэффициентов модели по МНК в этом случае невозможен. Гораздо чаще в экономических исследованиях встречается стохастическая мультиколлинеарность. В этом случае корреляционная связь между факторами высокая, определитель матрицы мал, а следовательно, велики элементы, в том числе диагональные, матрицы

мал, а следовательно, велики элементы, в том числе диагональные, матрицы . Эти элементы входят в формулы для расчета дисперсии коэффициентов модели и дисперсии расчетного и наблюдаемого значений зависимой переменной. Качество модели падает, так как модель становится чувствительной к незначительным изменениям в величине и объеме данных. Прогноз по такой модели теряет смысл, а коэффициенты могут не отвечать требованиям теоретических предпосылок.

. Эти элементы входят в формулы для расчета дисперсии коэффициентов модели и дисперсии расчетного и наблюдаемого значений зависимой переменной. Качество модели падает, так как модель становится чувствительной к незначительным изменениям в величине и объеме данных. Прогноз по такой модели теряет смысл, а коэффициенты могут не отвечать требованиям теоретических предпосылок.

Рассмотрим пример: Пусть точное уравнение, связывающее зависимую переменную с тремя объясняющими переменными, имеет вид

Прибавим к точным значениям  ошибку наблюдения

ошибку наблюдения  , получим наблюдаемые значения зависимой переменной

, получим наблюдаемые значения зависимой переменной  . Данные наблюдений отражает табл. 3.9.

. Данные наблюдений отражает табл. 3.9.

|

|

|

|

|

|

| 1,1 | 1,1 | 1,2 | 25,40 | 0,8 | 26,20 |

| 1,4 | 1,5 | 1,1 | 26,40 | -0,5 | 25,90 |

| 1,7 | 1,8 | 2,0 | 32,10 | 0,4 | 32,50 |

| 1,7 | 1,7 | 1,8 | 30,80 | -0,5 | 30,30 |

| 1,8 | 1,9 | 1,8 | 31,50 | 0,2 | 31,70 |

| 1,8 | 1,8 | 1,9 | 31,70 | 1,9 | 33,60 |

| 1,9 | 1,8 | 2,0 | 32,30 | 1,9 | 34,20 |

| 2,0 | 2,1 | 2,1 | 33,80 | 0,6 | 34,40 |

| 2,3 | 2,4 | 2,5 | 37,00 | -1,5 | 35,50 |

| 2,5 | 2,5 | 2,4 | 37,00 | 0,5 | 36,50 |

Переменные  сильно коррелируют друг с другом

сильно коррелируют друг с другом

Метод наименьших квадратов для наблюдаемой переменной y приводит к уравнению

Различие в моделях (3.38) и (3.39) очевидно. Поменялся даже знак коэффициента при  , что приводит к неверным выводам не только в количественном описании взаимодействия факторов с выходной переменной, но и в качественном. Использовать модель (3.39) невозможно.

, что приводит к неверным выводам не только в количественном описании взаимодействия факторов с выходной переменной, но и в качественном. Использовать модель (3.39) невозможно.

Существуют различные методы, которые могут быть использованы для смягчения мультиколлинеарности. Прежде всего к ним относятся методы, уменьшающие дисперсию оценок. К таким методам относятся: радикальное увеличение числа опытов; отбор из множества объясняющих переменных тех переменных, которые имеют наиболее низкие взаимные коэффициенты корреляции; на стадии подготовки данных максимизация дисперсии наблюдений независимых переменных путем расслоения выборки; уменьшение дисперсии остатков путем введения упущенной в первоначальной модели важной переменной.

Кроме того, для смягчения мультиколлинеарности используют внешнюю информацию о структуре модели, ввод ограничений на величину оценок или связи между коэффициентами модели.

Еще одним способом устранения мультиколлинеарности является переход от несмещенных оценок МНК с большой дисперсией к смещенным оценкам, но с гораздо меньшей дисперсией. В результате доверительный интервал той же длины для смещенного коэффициента будет с большей вероятностью накрывать истинный коэффициент. Метод построения модели, использующий эту идею, называется методом гребневой регрессии (ридж-регрессии). При этом расчет коэффициентов модели проводят по формуле

где

|

- | некоторое подбираемое исследователем положительное число, называемое гребнем; |

|

- | единичная матрица  -го порядка. -го порядка. |

Величина  выбирается исходя из условий компромисса между желанием уменьшить

выбирается исходя из условий компромисса между желанием уменьшить  - смещенность оценки

- смещенность оценки  - и стремлением уменьшить ее дисперсию за счет увеличения определителя матрицы

- и стремлением уменьшить ее дисперсию за счет увеличения определителя матрицы

Наконец, можно провести преобразование исходных данных, задействовать новые ортогональные факторы, называемые главными компонентами, и получить уравнение регрессии. Этот метод называется регрессией на главные компоненты.

3.10. Метод главных компонент

Основная идея метода заключается в замене сильно коррелированных переменных совокупностью новых переменных, между которыми корреляция отсутствует. При этом новые переменные являются линейными комбинациями исходных переменных

Переменные  называют главными компонентами. Будем подбирать их так, чтобы

называют главными компонентами. Будем подбирать их так, чтобы  имела наибольшую дисперсию. Для каждой следующей компоненты дисперсия убывает, а последняя компонента будет иметь наименьшую дисперсию. Предположим, исходные переменные

имела наибольшую дисперсию. Для каждой следующей компоненты дисперсия убывает, а последняя компонента будет иметь наименьшую дисперсию. Предположим, исходные переменные  уже стандартизированы так, что все переменные имеют нулевое математическое ожидание и единичную дисперсию. При этом матрица

уже стандартизированы так, что все переменные имеют нулевое математическое ожидание и единичную дисперсию. При этом матрица  является корреляционной матрицей для исходных данных.

является корреляционной матрицей для исходных данных.

Для первой главной компоненты  где

где  , справедливы равенства

, справедливы равенства

Как известно из теории положительно определенных симметричных матриц, невырожденная корреляционная матрица  имеет

имеет  положительных собственных значений и

положительных собственных значений и  соответствующих им ортогональных собственных векторов.

соответствующих им ортогональных собственных векторов.

Пусть  собственный вектор матрицы

собственный вектор матрицы  соответствующее ему собственное значение, т.е.

соответствующее ему собственное значение, т.е.  . Умножив последнее равенство слева на

. Умножив последнее равенство слева на  получаем

получаем  . Чтобы однозначно определить вектор

. Чтобы однозначно определить вектор  , введем дополнительное требование:

, введем дополнительное требование:  . Тогда

. Тогда  и проблема нахождения первой главной компоненты с максимальной дисперсией решается путем нахождения наибольшего собственного значения

и проблема нахождения первой главной компоненты с максимальной дисперсией решается путем нахождения наибольшего собственного значения  и соответствующего ему собственного вектора

и соответствующего ему собственного вектора  корреляционной матрицы

корреляционной матрицы  .

.

Аналогично находим вторую главную компоненту  при условии нормировки

при условии нормировки  и линейной независимости (ортогональности векторов)

и линейной независимости (ортогональности векторов)  . Дисперсия второй главной компоненты

. Дисперсия второй главной компоненты  будет равна второму по величине собственному значению

будет равна второму по величине собственному значению  матрицы

матрицы  . Убедимся, что главные компоненты

. Убедимся, что главные компоненты  и

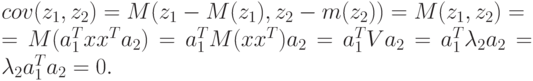

и  не коррелируют между собой. Действительно,

не коррелируют между собой. Действительно,

Продолжая процесс построения, получаем систему главных компонент, не коррелирующих друг с другом, с дисперсиями, равными собственным числам корреляционной матрицы  . Исходные переменные были сильно коррелированны, поэтому матрица

. Исходные переменные были сильно коррелированны, поэтому матрица  плохо обусловлена, т.е. ее определитель близок к нулю. Вместе с тем можно показать, что определитель

плохо обусловлена, т.е. ее определитель близок к нулю. Вместе с тем можно показать, что определитель  . Следовательно, одно или несколько последних собственных значений матрицы могут оказаться достаточно малы. Отбросив соответствующие главные компоненты, мы получаем возможность сократить размерность задачи, уменьшить число факторов в модели.

. Следовательно, одно или несколько последних собственных значений матрицы могут оказаться достаточно малы. Отбросив соответствующие главные компоненты, мы получаем возможность сократить размерность задачи, уменьшить число факторов в модели.

Применим метод главных компонент к рассмотренному выше примеру (см. табл. 3.4).

Составим корреляционную матрицу С и определим ее собственные векторы и собственные значения, используя, например, пакет МАТКАД.

Первая главная компонента имеет вид

Аналогично вычисляются остальные главные компоненты. Коэффициенты корреляции между  и главными компонентами

и главными компонентами  равны

равны  . Это еще раз подтверждает, что почти вся информация о линейной связи между

. Это еще раз подтверждает, что почти вся информация о линейной связи между  и

и  сводится к информации о связи между

сводится к информации о связи между  и первой главной компонентой

и первой главной компонентой  . Если написать уравнение регрессии, связывающее переменную

. Если написать уравнение регрессии, связывающее переменную  и

и  , а затем, используя уравнение (3.40), перейти к исходным переменным

, а затем, используя уравнение (3.40), перейти к исходным переменным  в естественной, а не в стандартизированной форме, то получим окончательное уравнение

в естественной, а не в стандартизированной форме, то получим окончательное уравнение

Уравнение (3.41) правильно отражает качественные свойства зависимостей и значительно ближе к точному уравнению (3.39), чем классическое МНК-уравнение (3.40).

.

.