| Россия, Волгоградская область |

Опубликован: 10.10.2014 | Уровень: для всех | Доступ: платный | ВУЗ: Московский государственный университет путей сообщения

Лекция 3:

Модификации генетических алгоритмов

Контрольные вопросы

- Какие методы применяются для генерации начальной популяции?

- Какая информация используется при отборе родителей?

- Какие недостатки имеет "метод рулетки"?

- Чем отличается ранжирование от пропорционального отбора?

- Что такое локальный отбор?

- Опишите метод турнирного отбора.

- Как используется метод Больцмана при отборе особей?

- Опишите методы отбора пар для скрещивания.

- Что такое неявные методы отбора?

- Опишите двоичную рекомбинацию.

- Чем отличается многоточечный кроссинговер от классического?

- Что такое однородный кроссинговер?

- Чем отличается рекомбинация действительных чисел от классического кроссинговера?

- Что такое дискретная рекомбинация?

- Опишите промежуточную рекомбинацию.

- Чем отличается линейная рекомбинация от промежуточной?

- Что такое инверсия?

- Как выполняется мутация над вещественными числами?

- Чем отличается неоднородная мутация от обычной?

- Какие существуют методы сокращения популяции?

- В каких случаях целесообразно применять генетический микроалгоритм?

- Опишите нестационарный ГА.

- Чем заменяется отбор родителей в нестационарном ГА?

- Какие методы определения сроков жизни вы знаете?

- Что такое ниши в ГА?

- Чем эволюция Ламарка отличается от эволюции Дарвина?

- Опишите гибридный ГА на основе эволюции Ламарка.

- В чем заключается адаптация в ГА?

- Как изменяются вероятности кроссинговера и мутации при адаптации?

- Какие виды адаптации ГА вы знаете?

- Как можно выполнить адаптацию числа особей популяции?

- Как можно выполнить адаптацию значений вероятностей кроссинговера и мутации.

- Опишите адаптивный ГА на основе нечетких контроллеров.

Упражнения

- Разработать программу, использующую ГА для нахождения экстремумов (минимумов) функции, согласно таблице вариантов, приведенной в табл.3.2 Программу выполнить на встроенном языке пакета Matlab.

- Для функций с числом переменных

вывести на экран график данной функции с указанием найденного экстремума, точек популяции. Для вывода графиков использовать стандартные возможности пакета Matlab. Предусмотреть возможность пошагового просмотра процесса поиска решения.

вывести на экран график данной функции с указанием найденного экстремума, точек популяции. Для вывода графиков использовать стандартные возможности пакета Matlab. Предусмотреть возможность пошагового просмотра процесса поиска решения. - Повторить нахождение решения с использованием стандартного Genetic Algorithm toolbox. Сравнить полученные результаты.

- Исследовать зависимость времени поиска, числа поколений (генераций), точности нахождения решения от основных параметров генетического алгоритма:

- число особей в популяции

- вероятность кроссинговера, мутации.

Критерий остановки вычислений – повторение лучшего результата заданное количество раз или достижение популяцией определенного возраста (например, 100 эпох).

- Повторить процесс поиска решения для

, сравнить результаты, скорость работы программы.

, сравнить результаты, скорость работы программы.

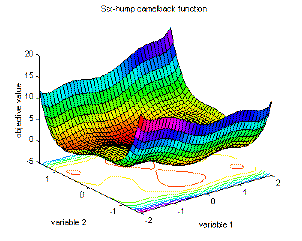

| № вв. | Название | Оптимум | Вид функции | График функции |

|---|---|---|---|---|

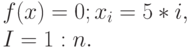

| 1 | De Jong's function 1 | global minimum

|

|

|

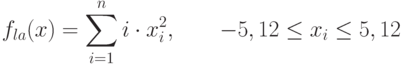

| 2 | Axis parallel hyper-ellipsoid function | global minimum

|

|

|

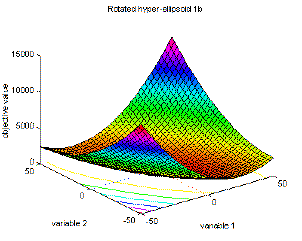

| 3 | Rotated hyper-ellipsoid function | global minimum

|

|

|

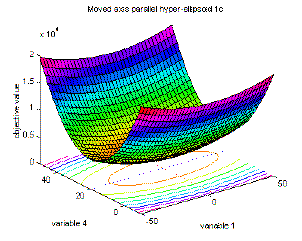

| 4 | Moved axis parallel hyper-ellipsoid function | global minimum

|

|

|

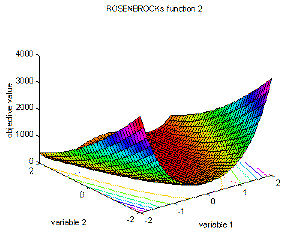

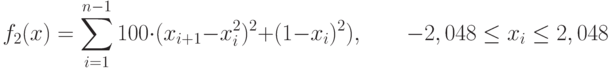

| 5 | Rosenbrock's valley (De Jong's function 2) | global minimum

|

|

|

| 6 | Rastrigin's function 6 | global minimum

|

|

|

| 7 | Schwefel's function 7 | global minimum

|

|

|

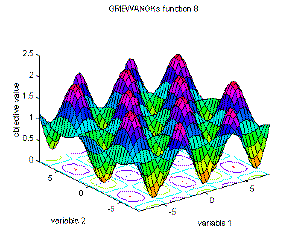

| 8 | Griewangk's function 8 | global minimum

|

|

|

| 9 | Sum of different power function 9 | global minimum

|

|

|

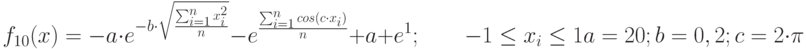

| 10 | Ackley's Path function 10 | global minimum

|

|

|

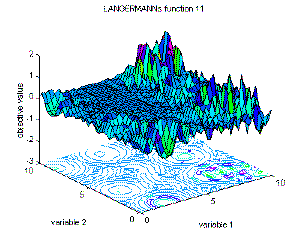

| 11 | Langermann's function 11 | global minimum

|

|

|

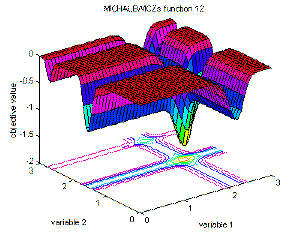

| 12 | Michalewicz's function 12 | global minimum

|

|

|

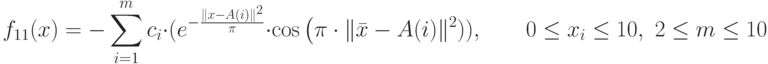

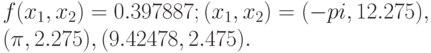

| 13 | Branins's rcos function | global minimum

|

|

|

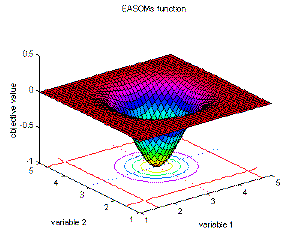

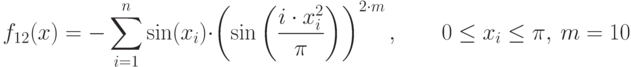

| 14 | Easom's function | global minimum

|

|

|

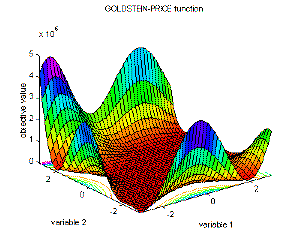

| 15 | Goldstein-Price's function | global minimum

|

|

|

| 16 | Six-hump camel back function | global minimum

|

|

Краткие итоги:

- рассмотрены различные модификации и обобщения ГА;

- описаны различные виды отбора родительских особей;

- показаны разные виды кодирования потенциальных решений;

- представлено множество генетических операторов кроссинговера и мутации;

- рассмотрены динамические ГА, где в процессе поиска изменяется мощность популяции;

- определены ГА на основе ниш для мультимодальных функций;

- описаны меметические ГА;

- рассмотрены гибридные ГА;

- представлены ГА на основе моделирования эволюции Ламарка;

- описаны различные виды адаптивных ГА, где при поиске решений изменяются параметры ГА