Регрессионный анализ в Gnumeric

6.1 Небольшое теоретическое введение

Всегда полезно знать, что и почему вычисляется в той или иной задаче. Поэтому сначала рассмотрим некоторые теоретические основы регрессионного анализа.

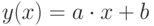

Линейный парный регрессионный анализ заключается в определении параметров эмпирической линейной зависимости (1), описывающей связь между некоторым  числом пар значений

числом пар значений  и

и  , обеспечивая при этом наименьшую среднеквадратическую погрешность (метод наименьших квадратов).

, обеспечивая при этом наименьшую среднеквадратическую погрешность (метод наименьших квадратов).

|

( 6.1) |

Графически это выглядит как проведение прямой в "облаке" точек с координатами  так, чтобы величина всех отклонений между значениями y на этой прямой при имеющихся значениях

так, чтобы величина всех отклонений между значениями y на этой прямой при имеющихся значениях  и координатами

и координатами  имеющихся точек отвечала условию (6.2).

имеющихся точек отвечала условию (6.2).

|

( 6.2) |

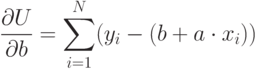

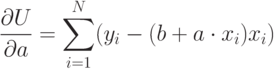

где  – теоретическая зависимость (6.1). Для этого нужно приравнять к нулю частные производные (6.3 и 6.4).

– теоретическая зависимость (6.1). Для этого нужно приравнять к нулю частные производные (6.3 и 6.4).

|

( 6.3) |

|

( 6.4) |

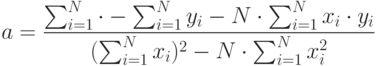

Тогда для определения коэффициентов линейной регрессии  и

и  получаем систему уравнений (6.5).

получаем систему уравнений (6.5).

|

( 6.5) |

Решение этой системы даётся соотношениями 6.6 и 6.7.

|

( 6.6) |

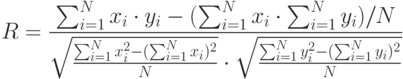

Для определения отклонения связи между  и

и  от линейной используется коэффициент парной корреляции (6.8).

от линейной используется коэффициент парной корреляции (6.8).

|

( 6.8) |

Если экспериментальная зависимость явно нелинейная, для её интерполяции (аппроксимации) применяются различные нелинейные зависимости (экспоненциальная, степенная с положительными или отрицательными показателями степени, полиномиальные различных порядков и пр.). При этом интерполяционная функция "линеаризуется", т. е. сводится к виду (6.1) путём замены переменных. Соответственно пересчитываются значения экспериментальных точек и коэффициент парной корреляции показывает успешность этого преобразования. Поскольку знак коэффициента парной корреляции при оценке качества линеаризации не является существенным, часто используется значение  .

.