| Россия, Ижевск, Ижевский государственный технический университет имени А.Т. Калашникова, 2011 |

Нелинейная динамика и синергетика. Искусственный интеллект

Информация, сигналы, данные, знания и управление. Обработка информации в условиях неопределенности

Информация — это одна из фундаментальных категорий жизни современного общества, охватывающая практически все сферы производственной, научной, культурной и социальной деятельности, которые базируются на информационных процессах.

Ценность информации определяется степенью её достоверности и полезности для владельца и пользователей. Практически ценность определяется её способностью "подтолкнуть" субъекта к определенным действиям, т.е. его способности на основании полученной информации принять решение и сформировать некоторое управляющее воздействие (табл. 1). В этом смысле термины в заголовке этого раздела неразрывно друг с другом связаны и не могут друг без друга существовать (как двуликий Янус или Инь и Янь в китайской философии). Информация, "не подталкивающая" к действию, — бессмысленна, так же как и бессмысленны какие-то действия без лежащей в их основе информации.

| Информация | Управление |

|---|---|

| Человек заболел | Принять лекарство |

| Дерево, около которого мы стоим, начинает падать | Отойти вбок от оси падения |

| Во всем доме погас электрический свет | Принять меры к исправлению повреждения в электроснабжении |

| Наметилась тенденция на существенное снижение курса акций из нашего инвестиционного портфеля | Начать продавать падающие акции |

| Зарегистрировано приближение подводной лодки противника к стратегически важному району | Отправить отряд кораблей для предотвращения проникновения подводной лодки противника или для контроля ее действий |

| В запретной зоне для полетов появился самолет противника | Постараться сбить вражеский самолет |

| В определенном регионе у населения существенно возрос интерес к выступлению некоторой эстрадной группы | Организовать концерт эстрадного коллектива в этом регионе |

Однако в большинстве случаев текущая информация быстро устаревает и ценность её уменьшается. Зависимость ценности информации от времени можно приближенно рассчитать по формуле:

,

,

где  — ценность информации в момент её возникновения,

— ценность информации в момент её возникновения,  — время от момента возникновения до момента определения стоимости,

— время от момента возникновения до момента определения стоимости,  — время от момента возникновения информации до её устаревания.

— время от момента возникновения информации до её устаревания.

Величина  может меняться в широком диапазоне: для процессов ядерного взаимодействия оно измеряется в наносекундах, информация же о законах природы остается актуальной в течение многих веков.

может меняться в широком диапазоне: для процессов ядерного взаимодействия оно измеряется в наносекундах, информация же о законах природы остается актуальной в течение многих веков.

Количественные характеристики информации (метрические свойства) можно определить следующими основными методами: комбинаторными, статистическими, алгоритмическими и метрологическими. Все эти методы опираются в основе на принцип разнообразия состояний информационной системы.

Комбинаторная логарифмическая мера количества информации по Р. Хартли проста для вычисления и удобна при расчетах в силу аддитивности логарифмической функции:

,

,

здесь  — коэффициент пропорциональности, обусловленный избранной мерой количества информации (например, при

— коэффициент пропорциональности, обусловленный избранной мерой количества информации (например, при  информация измеряется внатуральных числах; при

информация измеряется внатуральных числах; при  — в битах; при

— в битах; при  — в десятичных единицах),

— в десятичных единицах),  — число возможных дискретных состояний или число возможных сообщений о состоянии объекта или системы.

— число возможных дискретных состояний или число возможных сообщений о состоянии объекта или системы.

Из формулы видно, что эта мера инвариантна относительно любых свойств информации, безразмерна и в силу этого нечувствительна к содержанию информации в смысле её полезности. Из этого следует, что она практически бесполезна в задачах, где помимо количественных характеристик существенно смысловое содержание полученной информации.

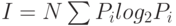

В статистическом методе используется энтропийный подход — количество информации оценивается мерой уменьшения у получателя неопределнности (энтропии) выбора или ожидания событий после получения информации. Количество информации должно быть тем больше, чем ниже вероятность события. Такой подход широко используется при оценке количества информации, передаваемой по каналам связи. Выбор при приеме информации осущевляется между символами алфавита в принятом сообщении. Пусть, например, принятое по каналу связи сообщение состоит из  символов (без учета связи между символами в сообщении). Тогда для определения количества информации

символов (без учета связи между символами в сообщении). Тогда для определения количества информации  в сообщении можно воспользоваться формулой К.Шеннона [Шеннон К., Уивер Л., 1956]:

в сообщении можно воспользоваться формулой К.Шеннона [Шеннон К., Уивер Л., 1956]:

,

,

где  — количество символов в алфавите языка,

— количество символов в алфавите языка,  — вероятность появления в сообщении символа с номером

— вероятность появления в сообщении символа с номером  .

.

Здесь количество информации в двоичном представлении (в битах или байтах) зависит от двух величин: количества символов в сообщении и частоты появления того или иного символа для используемого алфавита. Этот подход также не отражает, насколько полезна полученная информация — он позволяет лишь определить затраты на передачу сообщения.

Алгоритмическая мера информационной сложности по А.Н. Колмогорову основывется на модели вычислительного процесса и понятии вычислимой функции. Кратко определить эти понятия можно следующим образом. Пусть  — множество возможных исходных данных, из которых складывается информационное сообщение,

— множество возможных исходных данных, из которых складывается информационное сообщение,  — множество конечных результатов применения определенного алгоритма, причем множество

— множество конечных результатов применения определенного алгоритма, причем множество  , включающее множество

, включающее множество  , — область применения алгоритма. Пусть также функция

, — область применения алгоритма. Пусть также функция  задает отображение

задает отображение  , такое, что

, такое, что  совпадает с результатом применения алгоритма к объекту

совпадает с результатом применения алгоритма к объекту  . Тогда

. Тогда  назывется вычислимой функцией, которая задается алгоритмом. Пусть далее рассматривается некоторое исходное множество объектов и устанавливается взаимно-однозначное соответствие между этим множеством и множеством двоичных слов конечной длины, т.е. слов вида

назывется вычислимой функцией, которая задается алгоритмом. Пусть далее рассматривается некоторое исходное множество объектов и устанавливается взаимно-однозначное соответствие между этим множеством и множеством двоичных слов конечной длины, т.е. слов вида  где

где  есть 1 или

есть 1 или  . Модуль

. Модуль  обозначает длину слова

обозначает длину слова  .

.

Конечное двоичное слово можно описать так, что его можно восстановить по его описанию. Например, двоичное слово 110001 10001 1000 словесно описать как "две единицы и три двойки, повторенные три раза подряд". Разные слова имеют разные описания, но и одно слово также может иметь несколько описаний. Возникает вопрос: как сравнивать между собой описания двоичного слова, чтобы выбрать из них самое простое?

Будем считать, что описание двоичного слова задается не словесно, а также в виде двоичного слова — аргумента некоторой вычислимой функции  . Для некоторого двоичного слова

. Для некоторого двоичного слова  существет множество

существет множество  всех двоичных слов, таких, что

всех двоичных слов, таких, что  . Пусть далее

. Пусть далее

В этом случае  можно назвать сложностью слова

можно назвать сложностью слова  по

по  . Таким образом, сложность слова

. Таким образом, сложность слова  по

по  — это длина самого короткого двоичного слова, в котором содержится полное описание слова

— это длина самого короткого двоичного слова, в котором содержится полное описание слова  при фиксированном способе восстановления слов по их описаниям, т.е. при фиксированной функции

при фиксированном способе восстановления слов по их описаниям, т.е. при фиксированной функции  .

.

Тезаурусный подход — это рассмотрение информации с точки зрения количества полезных знаний, содержащихся в этом объеме. Согласно Ю.А.Шрейдеру, количество информации, извлекаемое человеком из сообщения, оценивается степенью изменения его знаний об объекте. Структурированные знания, представленные в виде понятий и отношений между ними, называются тезаурусом. Для передачи знаний необходимо, чтобы тезаурусы отправителя информации и получателя пересекались, иначе владельцы тезаурусов не поймут друг друга. Примером может служить принятое сообщение на чужом языке. В обществе сформировались две тенденции: развитие тезаурусов отдельных элементов (людей, сообществ, организованных структур) и выравнивание тезаурусов элементов общества.

Метрологический метод основан на количественном измерении объема информации, измеряемом количеством бит, количеством страниц текста, количеством файлов или длиной магнитной ленты или объемом диска с аудио или видеозаписью. Следует понимать, что этот метод использует относительные меры, так как одна и та же страница, лента, диск могут содержать разное количество информации — всё зависит от способа её кодирования и сжатия.

Рассмотренные формализованные подходы к формированию количественных мер не дают достаточной возможности для измерения и количественного описания ценности информации (прагматических характеристик) и содержательности (семантических характеристик). Прагматические характеристики можно подразделить на три группы.

В первую группу входят характеристики полезности информации на получателя, степень её влияния на состояние получателя и т. д. Ко второй группе относятся характеристики по качеству её связи с источником. Это характеристики важности информации для функционирования источника и показатели интенсивности генерации информации.

И, наконец, третья группа характеризуется внутренним качеством информации. Это такие качественные характеристики, как истинность, избыточность, полнота, актуальность, соответствие ожиданиям, степень обобщенности.

Напомним ещё раз, что полезность информации определяется тем, в какой степени она обеспечивает пользователю достижение поставленных целей. Данная характеристика тесно связана с характеристикой истинности информации, так как только максимальное сочетание истинности и полезности может уменьшить неопределенность ситуации и увеличить тем самым вероятность принятия правильного управленческого решения.

Обычно мы рассматриваем информацию как сообщение о том, что что-то произошло, т.е. одна из важнейших ее черт — изменение чего-то (объекта информации). Но информация возникает у кого-то или в чем-то (субъект информации).

Норберт Винер более шестидесяти лет тому назад провозгласил начало эры новой науки — кибернетики, одним из первых четко подметив, что "информационно-управленческая связь — это существенная часть любых явлений в живой и не живой природе" [Н. Винер, 1948].

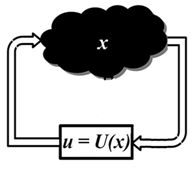

Введем для информации обозначение  , а для управления —

, а для управления —  . Процесс принятия управленческого решения формализовано может быть записан как

. Процесс принятия управленческого решения формализовано может быть записан как  ,

,  — некоторая функция от

— некоторая функция от  . Часто информацию x отождествляют с вектором состояний исследуемой системы. В этом случае говорят, что указанное выше соотношение задает обратную связь по состоянию.

. Часто информацию x отождествляют с вектором состояний исследуемой системы. В этом случае говорят, что указанное выше соотношение задает обратную связь по состоянию.

Реализация управления естественно влияет на информацию, способствуя новым изменениям объекта информации. Сформированное управление  поступает в систему и воздействует на состояние

поступает в систему и воздействует на состояние  , во многих случаях изменяя его. Связь между информацией и управлением можно представить в виде схемы рис. 2.3.

, во многих случаях изменяя его. Связь между информацией и управлением можно представить в виде схемы рис. 2.3.

Понимание неразрывной связи информации и управления снимает актуальность споров о первичности бытия или сознания, о поиске ответа на вопрос: что раньше — слово или дело?

Формализация процесса принятия решений приводит к необходимости определения понятий: сигналы, данные и знания.

Информация проявляет себя через изменения в тех или иных физических или социальных явлениях. Например, у заболевшего человека повышается температура тела. При падении дерева органы слуха фиксируют изменения в окружающих нас звуках, а глаза — изменения в отображаемой картинке.

При движении подводной лодки от ее гребных винтов распространяются специфические акустические волны. При приближении самолета и попадании его в зону видимости нашего радара от него отражается посылаемая радаром электромагнитная волна. Социальные изменения проявляются через выборочные опросы, голосования и т.п.

Физические и социальные явления и процессы, изменение которых можно зарегистрировать с помощью органов чувств или приборов, называются сигналами. Результаты регистрации называются данными.