|

К сожалению, многие фишки Ядекса перечисенные в этом курсе больше не поддерживаются. Курс морально устарел. |

Инструменты вебмастера

Мои сайты

Раздел "Мои сайты" содержит перечень ресурсов, которые могут управляться Вами. Это своего рода отправная точка мониторинга своих сайтов. Поначалу список пустой, поэтому мы вводим адрес сайта и нажимаем на кнопку "Добавить" ( рис. 4.8):

Спустя некоторое время, после того как сайт будет проиндексирован, отчет будет содержать информацию об этом ( рис. 4.9):

Глядя на этот список, возникает вопрос - а могу ли я таким образом добавить совершенно чужой сайт? Специально для предотвращения таких случаев сделана система проверки прав на управления. Она включает в себя предложение загрузить определенную информацию на ваш сайт. Если получится это сделать, то Яндекс будет считать вас владельцем сайта. Другими словами, владелец сайта может изменять его содержимое, что и проверит Яндекс.

В нашем случае мы авторизованы от имени пользователя v-rn@narod.ru, который автоматически является владельцем сайта v-rn.narod.ru. Поэтому никаких предложений проверить права на управления не возникает - мы автоматически получаем статус подтвержденных прав.

Под ошибками сайта понимаются случаи, когда поисковый бот не мог получить доступ к определенным страницам. Это могут быть и банальные несуществующие страницы (ошибки 404) или же ссылки на защищенные части сайта, которые запрещены для индексирования (см. далее файл "robots.txt" ).

Поле "Загружено страниц" отображает общее число страниц сайта, которые успел обойти поисковый бот Яндекса.

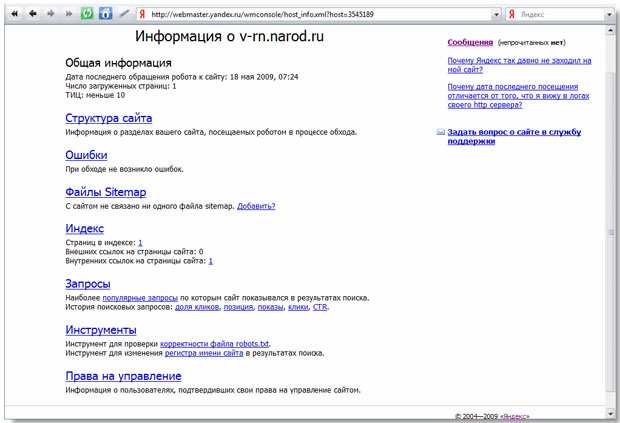

На рис. 4.9 гиперссылка на названии сайта ведет не на сам сайт, а на сводную страницу информации ( рис. 4.10):

Гиперссылка "Структура сайта" ведет на структуру, которую, опять-таки, видит Яндекс. Здесь отображаются только те подразделы, которые содержат более 10 страниц и занимают более 1% от общего числа. Поэтому реальная структура - та, которую мы могли видеть на локальном компьютере или на FTP, будет отличаться от представленной.

Файлы Sitemap - отличное средство указать приоритет индексации страниц для сайтов, содержимое которых часто обновляется. Например, большинство новостных лент содержат подразделы, на которых часто публикуются новости. Другие подразделы - архив, информация о сайте (или компании), список рассылок - обновляются реже. Быстрая индексация наиболее обновляемых материалов позволит отображать в поисковой выдаче актуальные данные, а значит, будет способствовать привлечению на ресурс новых посетителей. Для создания файлов Sitemap используется разметка XML, конкретные спецификации которой представлены на официальном сайте.

Раздел "Индекс" содержит очень интересную информацию и инструменты ( рис. 4.11):

В конце августа 2007 года Яндекс перестал поддерживать такие возможности, как поиск страниц, содержащих ссылку на данную, поиск слов, содержащихся только в текстах ссылок на данную. Они были удобны для использования как владельцами сайтов, так и ""роботами" — программами, написанными с целью изучить ранжирование Яндекса и попытаться им манипулировать". Поскольку такое манипулирование ухудшало качество поиска, то соответствующие инструменты были выключены. Так вот, а раздел "Индекс" позволяет все же просмотреть, какие внешние страницы ссылаются на подраздел вашего сайта с помощью инструмента "Внешние ссылки". Другими словами, в какой-то мере прежняя функциональность доступна в этом сервисе.

Раздел "Запросы" позволяет видеть, по каким поисковым словам сайт оказывается в результатах поиска ( рис. 4.12):

В еще одном инструменте для веб-мастеров - Яндекс.Метрике, который мы рассмотрим позже, есть дублирующие этот раздел средства.

Раздел "Инструменты" содержит, как это следует из названия, инструменты для проверки файла robots.txt и изменения регистра имени сайта в результатах поиска ( рис. 4.13):

Как правило, в любом сайте есть разделы, которые не должны индексироваться поисковыми системами. Это административные папки, персональные данные пользователей, рабочие материалы. Для того чтобы сообщать всем поисковым системам и Яндексу, в частности, что какие-то разделы обходить не нужно, используется помещение обычного текстового файла "robots.txt" в корневую директорию сайта, причем название файла должно быть точно таким. Например, на настоящем сайте этот файл лежит здесь: http://www.intuit.ru/robots.txt Мы видим его содержимое:

User-Agent: * Disallow: /cgi-bin/ Disallow: /w2k-bin/ Disallow: /admin/ Disallow: /w2admin/ Disallow: /user/ Disallow: /css/ Disallow: /diploma/

Язык этого файла довольно простой - это не какое-то программирование или даже не HTML-код. В данном случае для всех поисковых систем - "User-Agent: *" запрещено индексирование директорий cgi-bin, w2k-bin, admin и т.д. со всем их содержимым. Создадим свой собственный файл robots.txt для нашего сайта. Для примера, запретим индексирование определенной папки. Идем в Мастерскую, и нажимаем на ссылку "Создать папку" ( рис. 4.14):

Название папки может быть совершенно произвольным, но придерживаясь определенных традиций, назовем ее admin ( рис. 4.15):