|

Добрый день! Я ранее заканчивал этот курс бесплатно. Мне пришло письмо что я могу по этому курсу получить удостоверение о повышении квалификации. Каким образом это можно сделать не совсем понятны шаги кроме как вновь записаться на этот курс. С уважением Жолондиевский Эрнесто Робертович. |

Меры информации в системе

2. Мера К. Шеннона. Формула Шеннона дает оценку информации независимо, отвлеченно от ее смысла:

где n - число состояний системы; рi - вероятность (или относительная частота) перехода системы в i-е состояние, причем сумма всех pi равна 1.

Если все состояния равновероятны (т.е. рi=1/n ), то I=log2n.

К. Шенноном доказана теорема о единственности меры количества информации. Для случая равномерного закона распределения плотности вероятности мера Шеннона совпадает с мерой Хартли. Справедливость и достаточная универсальность формул Хартли и Шеннона подтверждается и данными нейропсихологии.

Пример. Время t реакции испытуемого на выбор предмета из имеющихся N предметов линейно зависит от log2N: t=200+180log2N (мс). По аналогичному закону изменяется и время передачи информации в живом организме. Один из опытов по определению психофизиологических реакций человека состоял в том, что перед испытуемым большое количество раз зажигалась одна из n лампочек, на которую он должен был указать в ходе эксперимента. Оказалось, что среднее время, необходимое для правильного ответа испытуемого, пропорционально не числу n лампочек, а именно величине I, определяемой по формуле Шеннона, где pi - вероятность зажечь лампочку номер i

Легко видеть, что в общем случае

Если выбор i-го варианта предопределен заранее (выбора, собственно говоря, нет, pi=1 ), то I=0.

Сообщение о наступлении события с меньшей вероятностью несет в себе больше информации, чем сообщение о наступлении события с большей вероятностью. Сообщение о наступлении достоверно наступающего события несет в себе нулевую информацию (и это вполне ясно: событие всё равно произойдет когда-либо).

Пример. Если положение точки в системе известно, в частности, она - в k-ой клетке, т.е. все рi=0, кроме рk=1, то тогда I=log21=0 и мы здесь новой информации не получаем (как и следовало ожидать).

Пример. Выясним, сколько бит информации несет произвольное двузначное число со всеми значащими цифрами (отвлекаясь при этом от его конкретного числового значения, т.е. каждая из возможных цифр может появиться на данном месте, в данном разряде с одинаковой вероятностью). Так как таких чисел может быть всего 90 (10-99), то информации будет количество I=log290 или приблизительно I=6,5. Так как в таких числах значащая первая цифра имеет 9 значений (1-9), а вторая - 10 значений (0-9), то I=log290=log29+log210. Приблизительное значение log210 равно 3,32. Итак, сообщение в одну десятичную единицу несет в себе в 3,32 больше информации, чем в одну двоичную единицу (чем log22=1 ), а вторая цифра, например, в числе аа, несет в себе больше информации, чем первая (если цифры а обоих разрядов неизвестны; если же эти цифры а известны, то выбора нет и информация равна нулю).

Если в формуле Шеннона обозначить fi=-nlog2 pi, то получим, что I можно понимать как среднеарифметическое величин fi.

Отсюда, fi можно интерпретировать как информационное содержание символа алфавита с индексом i и величиной pi вероятности появления этого символа в сообщении, передающем информацию.

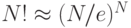

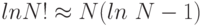

Пример. Пусть рассматривается алфавит из двух символов русского языка - "к" и "а". Относительные частоты встречаемости этих букв в частотном словаре русского языка равны соответственно p1=0.028, p2=0.062. Возьмем произвольное слово p длины N из k букв "к" и m (k+m=N) букв "а" над этим алфавитом. Число всех таких возможных слов, как это следует из комбинаторики, равно n=N!/(k! m!). Оценим количество информации в таком слове: I=log2n=lnn/ln2=log2e[lnN!-lnk!-lnm!]. Используя известную формулу Стирлинга (эта формула, как известно из математического анализа, достаточно точна при больших N, например, при N>100 ) -  ), а точнее, ее важное следствие, -

), а точнее, ее важное следствие, -  ), получаем оценку количества информации (в битах) на 1 символ любого слова:

), получаем оценку количества информации (в битах) на 1 символ любого слова:

![I_{1}=I/N\approx (log_{2}e/N)[(k+m)(ln\ N -1) - k(ln\ k-1) - m(ln m-1)]=

\\

=(log_{2}e/N)[k\ ln(N/k) - m ln(N/m)]=

\\

= - log_{2}e[(k/N)\ ln(k/N) + (m/N)\ ln(m/N)]\le

\\

\le -log_{2}e [p_{1} ln p_{1}+p_{2} ln p_{2}]=

\\

=-log_{2}e[0,028 ln0,028+0,062 ln0,062]\approx 0,235.](/sites/default/files/tex_cache/8d7619291e8c756a3cc2d9c6e2c2909d.png)

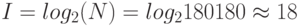

Пример. В сообщении 4 буквы "a", 2 буквы "б", 1 буква "и", 6 букв "р". Определим количество информации в одном таком (из всех возможных) сообщений. Число N различных сообщений длиной 13 букв будет равно величине: N=13!/(4!x2!x1!x6!)=180180. Количество информации I в одном сообщении будет равно величине:  (бит).

(бит).

Если k - коэффициент Больцмана, известный в физике как k=1.38x10-16 эрг/град, то выражение

в термодинамике известно как энтропия, или мера хаоса, беспорядка в системе. Сравнивая выражения I и S, видим, что I можно понимать как информационную энтропию ( энтропию из-за нехватки информации о/в системе).

Л. Больцман дал статистическое определение энтропии в 1877 г. и заметил, что энтропия характеризует недостающую информацию. Спустя 70 лет, К. Шеннон сформулировал постулаты теории информации, а затем было замечено, что формула Больцмана инвариантна информационной энтропии, и была выявлена их системная связь, системность этих фундаментальных понятий.

Важно отметить следующее.

Нулевой энтропии соответствует максимальная информация. Основное соотношение между энтропией и информацией:

I+S(log2e)/k=const

или в дифференциальной форме

dI/dt= -((log2e)/k)dS/dt.

При переходе от состояния S1 с информацией I1 к состоянию S2 с информацией I2 возможны случаи:

- S1 < S2 (I1 >I2) - уничтожение (уменьшение) старой информации в системе;

- S1 = S2 (I1 = I2) - сохранение информации в системе;

- S1 > S2 (I1 < I2) - рождение новой (увеличение) информации в системе.

Главной положительной стороной формулы Шеннона является ее отвлеченность от семантических и качественных, индивидуальных свойств системы. В отличие от формулы Хартли, она учитывает различность, разновероятность состояний - формула имеет статистический характер (учитывает структуру сообщений), делающий эту формулу удобной для практических вычислений. Основной отрицательной стороной формулы Шеннона является то, что она не различает состояния (с одинаковой вероятностью достижения, например), не может оценивать состояния сложных и открытых систем и применима лишь для замкнутых систем, отвлекаясь от смысла информации. Теория Шеннона разработана как теория передачи данных по каналам связи, а мера Шеннона - мера количества данных и не отражает семантического смысла.

Увеличение (уменьшение) меры Шеннона свидетельствует об уменьшении (увеличении) энтропии (организованности) системы. При этом энтропия может являться мерой дезорганизации систем от полного хаоса ( S=Smax ) и полной информационной неопределенности ( I=Imin ) до полного порядка ( S=Smin ) и полной информационной определённости ( I=Imax ) в системе.