|

как начать заново проходить курс, если уже пройдено несколько лекций со сданными тестами? |

Необходимые сведения о случайных величинах

5.2 Элементы теории информации

Кратко перечислим основные понятия, более подробное изложение можно найти в [1], [2], [3].

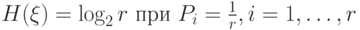

5.2.1 Энтропия

Количественной мерой неопределенности служит энтропия. Пусть задана дискретная случайная величина  , принимающая значения

, принимающая значения  с вероятностями

с вероятностями  соответственно.

соответственно.

Определение 5.10 Энтропия случайной величины  определяется равенством:

определяется равенством:

где  .

.

Свойства энтропии:

-

.

.

Пример 5.3 [3] Пусть имеется три источника сообщений, которые порождают буквы  и

и  , иными словами, есть три случайные величины

, иными словами, есть три случайные величины  , принимающие значения

, принимающие значения  и

и  :

:

Вычисления дают:  ,

,  бит,

бит,  бит.

бит.

И мы видим, что неопределенность этих случайных величин разная.

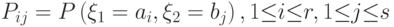

Пусть двумерная случайная величина задана распределением

Определение 5.11 Энтропия двумерной случайной величины задаётся формулой:

Пусть имеются дискретные случайные величины  и

и  , заданные вероятностными распределениями

, заданные вероятностными распределениями  ,

,  . Для них можно вычислить совместное распределение

. Для них можно вычислить совместное распределение  и условные распределения

и условные распределения  ,

,  для любых фиксированных значений

для любых фиксированных значений  ,

,  .

.

Определение 5.12 Условная энтропия  задаётся формулой:

задаётся формулой:

Определение 5.13 Условной энтропией двух вероятностных распределений называется усредненная (по всем  величина

величина  :

: